Jeder, der einen Chatbot wie ChatGPT benutzt hat, hat das bemerkt: Nach einer Weile scheint die KI plötzlich zu „vergessen“, was zuvor gesagt wurde. Das kann frustrierend sein — aber tatsächlich ist es eine direkte Folge davon, wie Large Language Models (LLMs) entworfen werden.

Jedes LLM arbeitet in einem Kontext-Fenster — im Wesentlichen sein Kurzzeitgedächtnis. Dieses Fenster definiert, wie viel Text (gemessen in Tokens) das Modell in einer Sitzung berücksichtigen kann.

Ältere Modelle wie GPT-3 handelten rund 4.000 Token. Aktuelle Versionen von GPT-4 verarbeiten 32.000—128.000 Token, Anthropic Claude sogar bis zu 200.000 — genug, um mehrere Romane abzudecken. Dennoch — sobald dieses Limit erreicht ist, werden ältere Teile der Konversation abgeschnitten (Casciato, 2025; Van Droogenbroeck, 2025).

Um dies ins rechte Licht zu rücken: Ein Zeichen entspricht in etwa drei Vierteln eines englischen Wortes. Das bedeutet, dass ein Fenster mit 4.000 Tokens ungefähr 3.000 Wörter aufnehmen könnte — ungefähr die Länge einer kurzen wissenschaftlichen Arbeit. Moderne Modelle mit Fenstern von 200.000 Zeichen können das Äquivalent eines Romans in voller Länge verarbeiten, doch selbst diese beachtliche Kapazität stößt bei längeren Konversationen an ihre Grenzen.

Wenn eine KI „vergisst“, erlebt sie keinen Gedächtnisverlust im menschlichen Sinne. Stattdessen werden die älteren Teile der Konversation buchstäblich aus der Eingabe entfernt, die verarbeitet wird. Das Modell hat keinen Zugriff auf Informationen, die außerhalb seines Kontextfensters liegen — es ist, als ob diese Konversation aus Sicht der KI nie stattgefunden hätte.

Dieser Prozess funktioniert in der Regel auf der Basis eines „Schiebefensters“. Wenn einer Konversation neue Nachrichten hinzugefügt werden, werden die ältesten Nachrichten systematisch entfernt, um Platz zu schaffen. Einige Systeme verwenden ausgefeiltere Strategien, z. B. die Beibehaltung der ursprünglichen Systemanweisungen und der kürzlich erfolgten Informationsaustausch, während die mittleren Teile entfernt werden, aber die grundlegende Einschränkung bleibt bestehen.

Die Einschränkung ist kein Fehler, sondern ein bewusster Kompromiss. Der Rechenaufwand von Transformatormodellen steigt quadratisch mit eingegebener Länge. Ohne eine Obergrenze würden die Antworten unerschwinglich langsam und teuer werden.

Darüber hinaus forschen wie „Verloren in der Mitte“ (Liu et al., 2023) zeigt, dass Modelle lange Sequenzen nicht einheitlich verarbeiten — sie konzentrieren sich mehr auf den Anfang und das Ende der Eingabe, während Informationen in der Mitte dazu neigen, übersehen zu werden.

Diese quadratische Skalierung bedeutet, dass die Verdoppelung der Kontextlänge die Rechenanforderungen ungefähr vervierfacht. Für ein Unternehmen, das Millionen von Benutzern gleichzeitig bedient, bedeutet dies enorme Infrastrukturkosten und einen enormen Energieverbrauch. Selbst mit der fortschrittlichsten Hardware gibt es praktische Grenzen dafür, wie viel Kontext in Echtzeit verarbeitet werden kann, während gleichzeitig angemessene Reaktionsgeschwindigkeiten eingehalten werden.

Der Aufmerksamkeitsmechanismus, der diese Modelle antreibt, steht auch bei sehr langen Sequenzen vor inhärenten Herausforderungen. Wenn der Kontext wächst, muss das Modell die Beziehungen zwischen exponentiell mehr Token-Paaren berechnen, was zu dem führt, was Forscher als „Aufmerksamkeitsverdünnung“ bezeichnen — bei der wichtige Verbindungen im Lärm der Verarbeitung riesiger Informationsmengen verloren gehen.

Diese Einschränkungen manifestieren sich auf verschiedene Arten, denen Benutzer täglich begegnen. In Kundendienstanwendungen kann eine KI bei einem komplexen technischen Problem, das mehrere Börsen umfasst, den Überblick verlieren. In Bildungskontexten vergessen KIs unter Umständen frühere Erklärungen, wenn sie Schülern helfen, mehrstufige Probleme zu lösen. Assistenten für kreatives Schreiben verlieren bei längeren Geschichten möglicherweise an konsistenter Erzählung, sodass Benutzer die KI wiederholt an Charakterdetails und Handlungspunkte erinnern müssen.

Professionelle Anwendungen spüren diese Einschränkungen akut. Bei der Analyse von Rechtsdokumenten, medizinischen Konsultationssystemen und Diskussionen über Geschäftsstrategien ist es häufig erforderlich, den Kontext in umfangreichen Dialogen beizubehalten. Aufgrund der aktuellen Speicherbeschränkungen ist bei solchen Anwendungen häufig ein sorgfältiges Gesprächsmanagement oder eine externe Dokumentation erforderlich, um die Kontinuität aufrechtzuerhalten.

Forscher und Entwickler experimentieren mit mehreren Strategien:

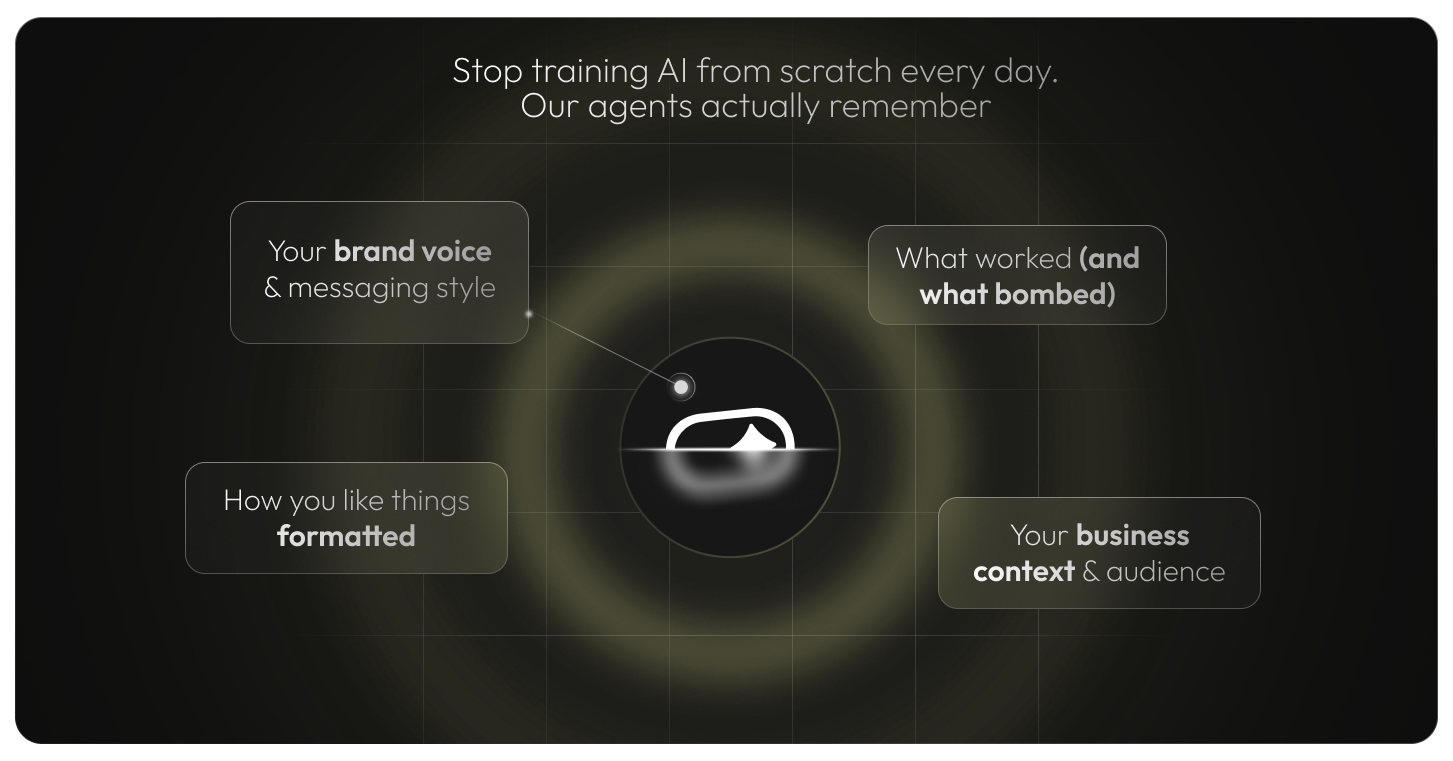

Einige Unternehmen implementieren clevere Problemumgehungen. Vektor-Datenbanken können Einbettungen von Konversationen speichern, die die semantische Bedeutung erfassen, sodass Systeme relevante Diskussionen aus der Vergangenheit abrufen können, ohne komplette Transkripte speichern zu müssen. Bei der hierarchischen Zusammenfassung werden verschachtelte Zusammenfassungen mit unterschiedlichen Detaillierungsgraden erstellt, wobei sowohl der allgemeine Kontext als auch spezifische Details bei Bedarf beibehalten werden.

Interessanterweise ist „Vergessen“ nicht immer eine Schwäche — manchmal ist es ein Merkmal. OpenAI (2024) und Google (2025) eingeführt steuerbare Speicherfunktionen, sodass Benutzer entscheiden können, was gespeichert wird, oder sich für temporäre „Inkognito-Chats“ entscheiden, die automatisch gelöscht werden. Dies spiegelt ein empfindliches Gleichgewicht zwischen technischem Fortschritt und Datenschutz wider.

Die Auswirkungen des KI-Gedächtnisses auf den Datenschutz sind tiefgreifend. Systeme mit persistentem Speicher werfen Fragen zum Besitz von Daten, zur Einwilligung und zum Recht auf Vergessenwerden auf. Benutzer können vertrauliche Informationen weitergeben, in der Annahme, dass sie nach Ende der Sitzung vergessen werden, nur um dann festzustellen, dass sie dauerhaft gespeichert wurden. Umgekehrt möchten Benutzer, die langfristige Beziehungen zu KI-Assistenten aufbauen, möglicherweise, dass bestimmte Präferenzen und der Kontext bestehen bleiben.

Verschiedene regulatorische Rahmenbedingungen verfolgen unterschiedliche Herangehensweisen an diese Herausforderungen. Die europäischen DSGVO-Anforderungen betonen die Kontrolle der Nutzer über personenbezogene Daten, während sich andere Jurisdiktionen stärker auf Offenlegungs- und Einwilligungsmechanismen konzentrieren. Dieser regulatorische Flickenteppich stellt globale KI-Systeme vor komplexe Herausforderungen, die ein ausgewogenes Verhältnis zwischen Speicherfunktionen und Datenschutzkonformität sicherstellen müssen.

Das Vergessenverhalten von KI-Systemen erzeugt auch interessante psychologische Dynamiken. Nutzer entwickeln häufig Erwartungen, die auf menschlichen Gesprächsmustern basieren, wobei das Vergessen eher schrittweise und selektiv als plötzlich und vollständig erfolgt. Dieses Missverhältnis kann zu Frustration führen und das Vertrauen in KI-Systeme verringern.

Einige Benutzer schätzen jedoch den Neuanfang, den das KI-Vergessen mit sich bringt. Sensible Gespräche, persönliche Probleme oder peinliche Momente dauern nicht ewig an. Dadurch entsteht ein einzigartiger Raum, in dem Benutzer mit Ideen experimentieren oder Hilfe suchen können, ohne befürchten zu müssen, langfristig beurteilt oder zurückgerufen zu werden.

Große KI-Entwickler verfolgen unterschiedliche Strategien, um Speicherbeschränkungen zu beheben. Einige konzentrieren sich darauf, die Kontextfenster durch effizientere Architekturen zu erweitern. Andere legen den Schwerpunkt auf externe Speichersysteme, auf die selektiv zugegriffen werden kann. Wieder andere erforschen biologische Metaphern und implementieren Gedächtnissysteme, die menschliche Vergessenkurven und Priorisierungsmechanismen widerspiegeln.

Die Wettbewerbslandschaft rund um das KI-Gedächtnis verschärft sich. Unternehmen, die das Speicherproblem erfolgreich lösen und gleichzeitig Geschwindigkeit, Wirtschaftlichkeit und Datenschutz beibehalten, können bei Anwendungen, die langfristige Benutzerbeziehungen erfordern, erhebliche Vorteile erzielen.

Die zentrale Frage ist nicht mehr wenn KI wird Gedächtnis haben, aber wie. Ein System, das sich an Benutzerpräferenzen erinnert, wirkt kompetenter, hilfreicher und menschlicher. Gleichzeitig erfordert das Langzeitgedächtnis eine sorgfältige Steuerung, um das Risiko einer Überspeicherung zu vermeiden.

Die Zukunft bietet wahrscheinlich eher ein Spektrum an Speicheroptionen als eine Einheitslösung. Verschiedene Anwendungen erfordern unterschiedliche Speicherarchitekturen — von kurzlebigen Systemen für datenschutzsensible Aufgaben bis hin zu umfassenden Speichersystemen für langfristige Partnerschaften. Benutzer erhalten möglicherweise eine feinkörnige Kontrolle darüber, was sich ihre KI-Assistenten merken, vergessen und priorisieren.

Wir befinden uns an einem Wendepunkt — die „vergesslichen“ Systeme von heute legen den Grundstein für die konsistenten, speicherfähigen Assistenten von morgen. Die Herausforderung besteht nicht nur darin, Systeme zu entwickeln, die sich erinnern können, sondern auch darin, Systeme zu bauen, die klug und ethisch denken und dem menschlichen Gedeihen dienen.

Referenzen (Auswahl)